- دواپس چیه و چرا لازمه؟ اینجا در مورد دواپس و ضرورت استفاده از آن صحبت کردم.

- چطور اپلیکیشن مناسب کلاد آماده کنیم؟ و اینجا توضیح دادم که چطور میتونیم یه اپلیکیشن مناسب کلاد توسعه بدیم.

- چه عمقی از لینوکس برای دواپس لازمه؟ و اینجا توضیح دادم که کدوم موارد لینوکس برای دواپس الزامی هست که اول سراغ اون موارد بریم.

- خودکارش کن,مشکلاتت حل میشه در اینجا در مورد اتومیشن و اینکه انسیبل چیه و چه کمکی به ما میکنه صحبت کردم.

- در مسیر دواپس اینبار اجزای اصلی انسیبل تو این پست اجزای انسیبل رو معرفی کردم و آنها را شرح دادم.

- در مسیر دواپس به داکر رسیدیم (قسمت اول) تو این پست داکر رو شروع کردیم و اونو معرفی کردیم.

- در مسیر دواپس اینبار: پشت داکر چه خبره؟ (قسمت دوم) توی این پست در مورد تکنولوژی هایی که داکر ازشون استفاده میکنه توضیح دادیم.

- تست نوشتن و شروع مسیر CI/CD (قسمت اول) توی این پست انواع تست رو بررسی کردیم و با ابزارهای CI/CD آشنا شدیم و یه مقایسه بین گیتلب و جنکینز داشتیم.

- در مسیر CI/CD گیت رو بررسی میکنیم (قسمت دوم) توی این پست قبل ورود به گیتلب نیاز بود که گیت و ورژن کنترل سیستم ها رو یه بررسی کنیم.

- در مسیر CI/CD شناخت گیتلب (قسمت سوم) توی این پست اجزای گیتلب رو بررسی کردیم و با کامپوننتهای مختلفی که داره بیشتر آشنا شدیم.

- در مسیر CI/CD پایپلاین و رانر گیتلب (قسمت چهارم) توی این پست پایپلاین و رانر گیتلب رو بررسی کردیم.

- در مسیر CI/CD وریبل، گیتآپس و جمعبندی (قسمت پنجم) توی این پست وریبلهای گیتلب رو بررسی کردیم و یه معرفی کوتاه از گیتآپس و آتودواپس کردیم و در انتها یه مقدار تجربههای خودم رو در گیتلب باهاتون به اشتراک گذاشتم.

- در مسیر Observability، الک (قسمت دوم) توی این پست استک قدرتمند ELK رو بررسی کردیم.

-

در مسیر Observability، جمع بندی استک الک (قسمت سوم) توی این پست بقیه کامپوننتهای استک الک رو بررسی کردیم و fluentd و fluentbit رو مقایسه کردیم و نهایتا یه معرفی هم روی opensearch داشتیم.

-

در مسیر Observability، استک پرومتئوس (قسمت چهارم) توی این پست یه معرفی اولیه داشتیم روی استک پرومتئوس.

-

در مسیر Observability، استک پرومتئوس (قسمت پنجم) توی این پست یه مقدار کامپوننت های استک پرومتئوس رو بیشتر بررسی کردیم.

-

در مسیر Observability، استک ویکتوریا (قسمت ششم) توی این پست استک ویکتوریا رو معرفی کردیم و سعی کردیم با پرومتئوس مقایسهاش کنیم.

-

در مسیر Observability، میمیر (قسمت هفتم) توی این پست در مورد ابزار میمیر از ابزارهای گرافانا توضیح دادیم و کاربردش رو بررسی کردیم.

-

در مسیر Observability، لوکی (قسمت هشتم) توی این پست در مورد ابزار گرافانا برای مدیریت لاگ یعنی لوکی توضیح دادیم و آخرشم یه معرفی کوتاه رو graylog داشتیم.

-

در مسیر Observability، تمپو (قسمت نهم) توی این پست در مورد تریسینگ توضیح دادیم و گرافانا تمپو رو بررسی کردیم و یه معرفی کوتاه روی Jaeger داشتیم

-

در مسیر Observability، گرافانا (قسمت دهم) توی این پست در مورد گرافانا و HA کردنش و همچنین یه سری از ابزارهاش مثل alloy , incident, on-call توضیح دادیم.

-

آغاز مسیر کوبر (قسمت اول) تو این قدم به معرفی ابزارهای ارکستریشن پرداختیم و مدارک کوبرنتیز رو بررسی کردیم.

-

کوبر سینگل ( قسمت دوم ) توی این قدم در مورد kubectl , kubeconfig توضیح دادیم و تعدادی ابزار رو معرفی کردیم که به کمک اونها میتونیم یک کوبرنتیز دمهدستی واسه تستهامون داشته باشیم.

-

کامپوننتهای کوبر ( قسمت سوم ) توی این پست کامپوننتهای مختلف کوبرنتیز رو بررسی کردیم و اجزای نودهای مستر و ورکر رو دونه دونه بررسی کردیم و توضیح دادیم.

-

پادها و مدیریت اونها در کوبرنتیز (قسمت چهارم) توی این پست در مورد پاد توی کوبرنتیز توضیح دادیم و موارد مربوط به اون رو بررسی کردیم.

-

ورکلودهای کوبر و مدیریت منابع کوبر (قسمت پنجم) توی این پست در مورد namespaceها توی کوبر توضیح دادیم و انواع ورکلود کوبر رو بررسی کردیم.

-

اگه لازم شد کوبر خودش گنده میشه! ( قسمت ششم ) توی این پست در مورد سه نوع ورکلود مرتبط با scaling به صورت خودکار در کوبرنتیز توضیح دادیم.

-

نتورک کوبر (قسمت هفتم) توی این قسمت انواع سرویس توی کوبرنتیز رو بررسی کردیم و در مورد مفاهیم اینگرس و نتورک پالیسی توضیح دادیم.

-

استورج کوبرنتیز (قسمت هشتم) توی این قسمت در مورد انواع استورج توی کوبرنتیز توضیح دادیم و مفاهیم PV و PVC و Storage Class رو بررسی کردیم.

-

پراب، ریکوئست و لیمیت (قسمت نهم) توی این قسمت موارد مربوط به محدود کردن منابع کانتینر توی کوبرنتیز رو بررسی کردیم و در مورد انواع probe ها توی کوبرنتیز توضیح دادیم.

-

پاد تو نود (قسمت دهم) توی این قسمت درمورد فرآیند انتقال پاد به نود مناسب مفاهیم پیشرفتهتری مثل affinity و anti-affinity و taint و toleration رو بررسی کردیم.

-

اولویت پاد و امنیت (قسمت یازدهم) توی این قسمت در مورد تعیین اولویت برای پادها و جنبههای مختلف امنیت در کوبرنتیز توضیح دادیم.

-

کنترل دسترسی به کوبر (قسمت دوازدهم) توی این قسمت در مورد مراحل دسترسی به api کوبرنتیز صحبت کردیم و بعدش مفاهیمی مثل سرویس اکانت رو توضیح دادیم.

-

دیزاین کلاستر (قسمت سیزدهم) توی این قسمت در مورد طراحی و دیزاین یک کلاستر و روشهای مختلفی که داره توضیح دادیم و همچنین تفاوت روشهای مختلف تقسیم منابع در کلاسترها را بررسی کردیم.

-

مالتی تننسی در کوبر (قسمت چهاردهم) توی این قسمت چالشهای مربوط به داشتن چند مستاجر بر روی کلاستر کوبرنتیز توضیح دادیم.

-

هلم (قسمت پانزدهم) توی این قسمت پکیج منیجر معروف کوبرنتیز یعنی Helm رو بررسی کردیم و در موردش ویژگیها و کاربردهاش توضیح دادیم.

-

سی آر دی و اُپراتور (قسمت شانزدهم) توی این قسمت در مورد اینکه چطوری یه ریسورس کاستوم شده به کلاستر اضافه کنیم توضیح دادیم و مفهوم اُپراتور رو توی کوبر بررسی کردیم.

-

نصب کلاستر با kubeadm (قسمت هفدهم) توی این قسمت قدم به قدم نحوه نصب یک کلاستر کوبرنتیز رو با استفاده از ابزار kubeadm توضیح دادیم.

-

نصب کلاستر با kubespray (قسمت هجدهم) توی این قسمت نحوه نصب کلاستر با یه پروژه خیلی خوب به نام کیوب اسپری که یه انسیبل خفن برای ستاپ کلاستر رائه میده رو توضیح دادیم.

-

نصب کلاستر با rancher (قسمت نوزدهم) توی این قسمت توضیح دادیم که چطور با استفاده از ابزار RKE یک کلاستر کوبرنتیز راهاندازی کنیم.

apiVersion: v1

kind: Service

metadata:

labels:

app: db

name: db

spec:

type: ClusterIP

ports:

- name: "db-service"

port: 5432

targetPort: 5432

selector:

app: db

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: db-pvc

labels:

app: db

spec:

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 1Gi

storageClassName: local-path

---

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: db

name: db

spec:

replicas: 1

selector:

matchLabels:

app: db

template:

metadata:

labels:

app: db

spec:

containers:

- image: postgres:15-alpine

name: postgres

env:

- name: POSTGRES_USER

value: postgres

- name: POSTGRES_PASSWORD

value: postgres

ports:

- containerPort: 5432

name: postgres

volumeMounts:

- mountPath: /var/lib/postgresql/data

name: db-data

volumes:

- name: db-data

persistentVolumeClaim:

claimName: db-pvc

---

قسمت بعدی سرویسی هست که میخوایم این پاد پستگرس رو بندازیم پشتش و از طریق اون به بقیه پادهای سرویسمون دسترسی دیتابیس رو بدیم. منطقا این سرویس باید از نوع ClusterIP باشه چونکه برای دسترسیهای داخل کلاستر میخوایم ازش استفاده کنیم. در قسمت port پورت مربوط به سرویس رو تعریف میکنیم و در قسمت تارگتپورت هم پورت مربوط به اون پاد که داره روی اون پورت سرویس میده. اگه در مورد مفاهیم نتورکی هم دوست دارید بیشتر بدونید میتونید این بلاگ پست رو بخونید.

apiVersion: v1

kind: Service

metadata:

labels:

app: redis

name: redis

spec:

type: ClusterIP

ports:

- name: "redis-service"

port: 6379

targetPort: 6379

selector:

app: redis

---

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: redis-pvc

labels:

app: redis

spec:

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 1Gi

storageClassName: local-path

---

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: redis

name: redis

spec:

replicas: 1

selector:

matchLabels:

app: redis

template:

metadata:

labels:

app: redis

spec:

containers:

- image: redis:alpine

name: redis

ports:

- containerPort: 6379

name: redis

volumeMounts:

- mountPath: /data

name: redis-data

volumes:

- name: redis-data

persistentVolumeClaim:

claimName: redis-pvc

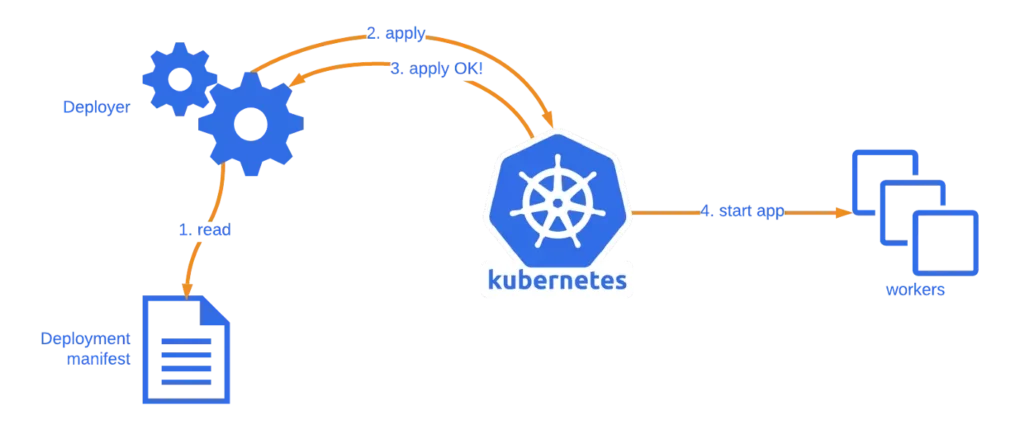

بعد از اینکه مانیفست دیتابیس رو به کلاستر اضافه کردیم میریم سراغ مانیفست سرویس redis، همونطور که میدونید فایل های مانیفست رو با دستور kubectl apply -f file-name.yml میتونیم به کلاستر اپلای کنیم و این ریسورسها رو اضافه کنیم. خب بریم مانیفست ردیس رو بررسی کنیم ابتدا از پایین یه deployment داریم که با رپلیکای یک، یک پاد ردیس رو از روی ایمیج redis:alpine میاره بالا که روی پورت ۶۳۷۹ سرویس میده و والیوم redis-data به اون مانت شده که از طریق pvc ساخته میشه. ریسورس بعدی همین pvc هست که مثل دیتابیس از استورج کلاس local-path با حجم یک گیگ اونو میسازیم و همچنین با دسترسی خواندن و نوشتن.

apiVersion: v1

kind: Secret

metadata:

name: registry-login

type: kubernetes.io/basic-auth

data:

username: a3ViZQ==

password: QW5JcXlpajFEWWw3cmU2WHRJaHY5R3JLYVBnMURYQXRNTTh1TkF1dQ==

# base64

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: worker

name: worker

spec:

replicas: 1

selector:

matchLabels:

app: worker

template:

metadata:

labels:

app: worker

spec:

imagePullSecrets:

- name: registry-login

containers:

- image: registry.mecan.ir/devops_certification/kubernetes/voting-app/worker:v0.1.0

name: worker

apiVersion: v1

kind: Service

metadata:

labels:

app: vote

name: vote

spec:

type: NodePort

ports:

- name: "vote-service"

port: 8080

targetPort: 80

nodePort: 31000

selector:

app: vote

---

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: vote

name: vote

spec:

replicas: 1

selector:

matchLabels:

app: vote

template:

metadata:

labels:

app: vote

spec:

imagePullSecrets:

- name: registry-login

containers:

- image: registry.mecan.ir/devops_certification/kubernetes/voting-app/vote:v0.1.0

name: vote

ports:

- containerPort: 80

name: vote

apiVersion: v1

kind: Service

metadata:

labels:

app: result

name: result

spec:

type: NodePort

ports:

- name: "result-service"

port: 8081

targetPort: 80

nodePort: 31001

selector:

app: result

---

apiVersion: apps/v1

kind: Deployment

metadata:

labels:

app: result

name: result

spec:

replicas: 1

selector:

matchLabels:

app: result

template:

metadata:

labels:

app: result

spec:

imagePullSecrets:

- name: registry-login

containers:

- image: registry.mecan.ir/devops_certification/kubernetes/voting-app/result:v0.1.0

name: result

ports:

- containerPort: 80

name: result